多传感器融合感知之整车传感器设计

本文是深蓝学院多传感器融合感知课程的笔记,主要从承接前文所总结的各个传感器的原理,对自动驾驶整车的传感器设计进行分析。

自动驾驶传感器需求

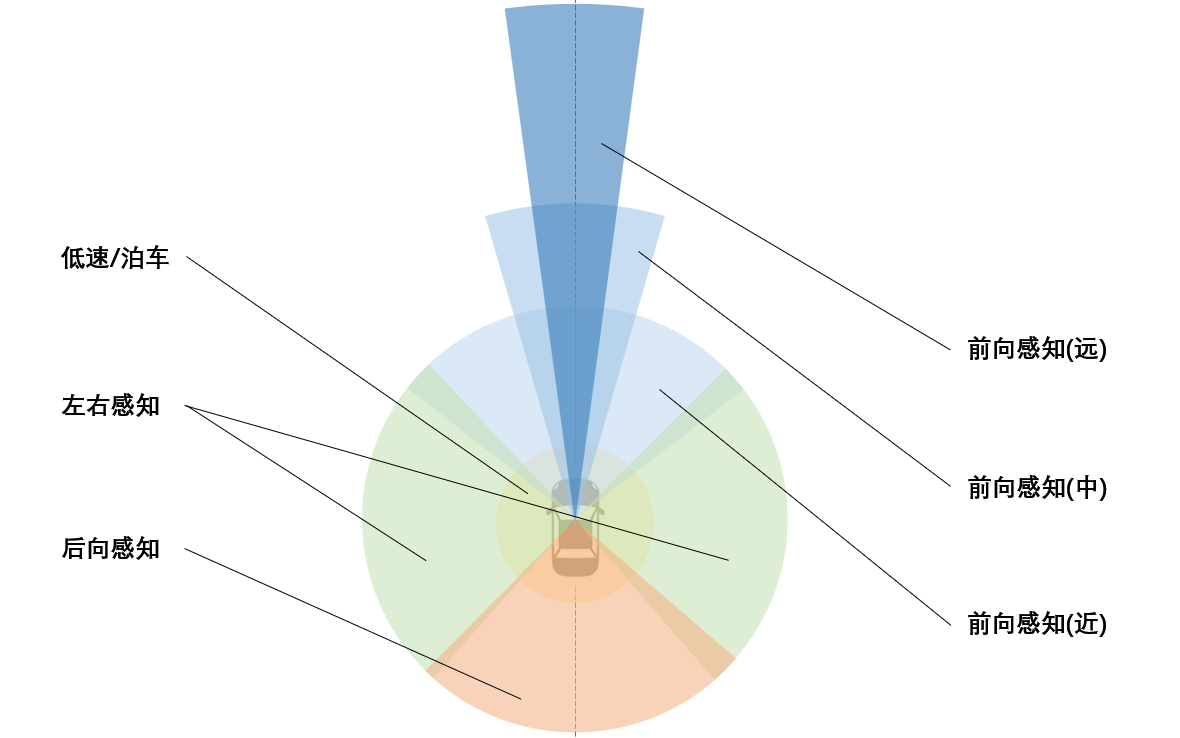

对于自动驾驶而言,需要对自车周边的环境信息进行实时的感知,但是考虑到传感器的功能以及成本的实现,一般来讲可以根据优先级的不同,将感知区域分为若干部分。

| 感知目标 | 感知方向 | 感知范围 | 优先级 | 冗余要求 |

|---|---|---|---|---|

| 低速/泊车 | 环向 | 0-10m | 最高 | 最高 |

| 前向行驶 | 前向 | 0-80m | 最高 | 最高 |

| 前向行驶 | 前向 | 80-120m | 中等 | 中等 |

| 前向行驶 | 前向 | 120-200m | 低等 | 低等 |

| 左右感知 | 横向 | 0-80m | 中等 | 中等 |

| 后向感知 | 后向 | 0-80m | 低等 | 低等 |

对应各区域的感知视野如下图所示

典型L2传感器系统

Tesla Autopilot

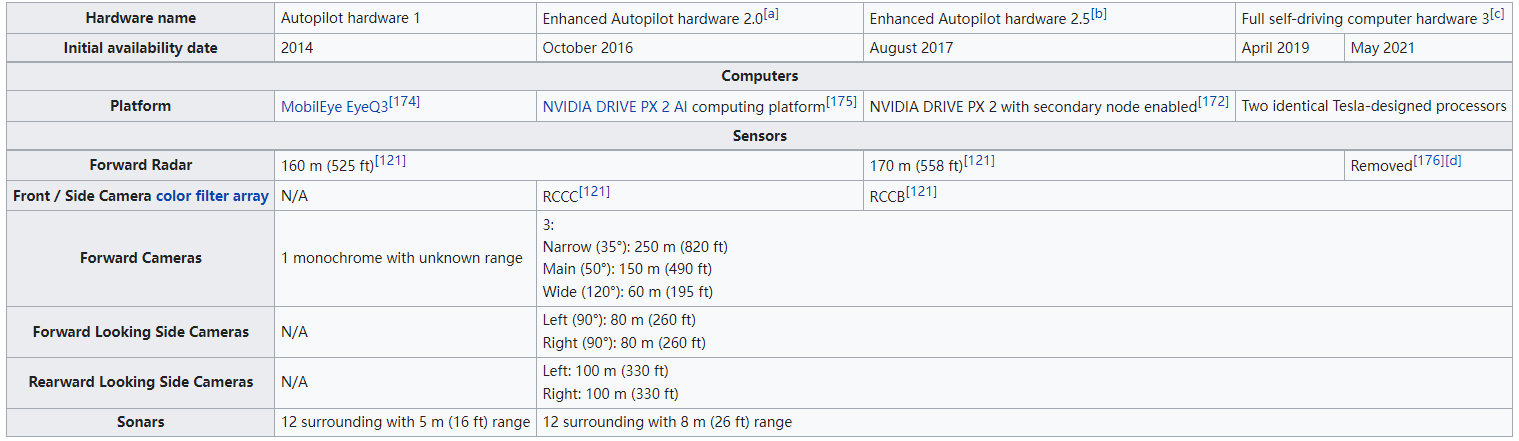

Autopilot从2014年上线至今,其实现了4个版本的迭代,值得注意的是2021年五月,前向的Radar传感器被彻底移除,也就是Tesla Pure Vision的方案,其版本迭代如下图所示

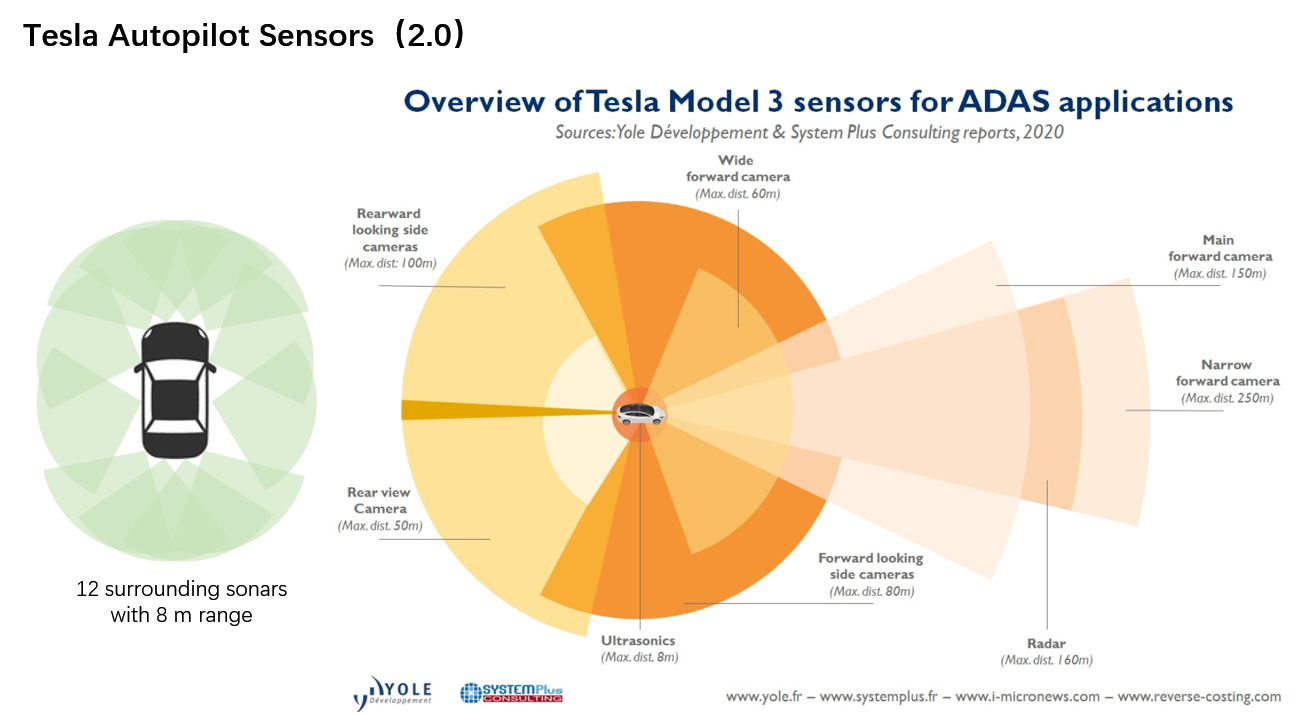

这里不讨论Tesla如何使用camera兼顾radar的功能的,仅以2.0版本为例,展示其传感器布置,如下图。

可以发现,Tesla使用超声波包围了ego周围的环境感知,一定程度上满足上述的0-10m的环向低速或泊车场景的感知要求。此外,相机的视野也基本覆盖ego周向的所有角度,并且前向3D相机着重突出了远距离感知的功能,并且使用一个可以覆盖160m范围的Radar。

NIO NAD

蔚来的感知传感器经历了两次变更,之前的叫NIO Pilot,被用在ES6、ES8等车型上,而在ET5、ET7这两个新车上,蔚来使用了升级后的传感器配置,详细对比如下:

可以发现,在NAD版本中蔚来使用了激光雷达、V2X以及升级了相机的参数配置。此外,NIO还使用了带有4颗Nvidia orin核心的处理器。

- 8MP相机,大概是2K的图像分辨率,相比于1.2MP,感知车辆的距离从229m - 687m,感知锥桶的距离从87m - 262m,行人则是从74m - 223m。

- 图达通innovusion半固态激光,最远探测距离可达500米远,10%反射率的标准探测距离为250米,ROI区域可达0.06°x0.06°超高分辨率,且支持动态聚焦

- 此外,使用了4个环视的3MP相机,并添加了车路协同V2X模块。

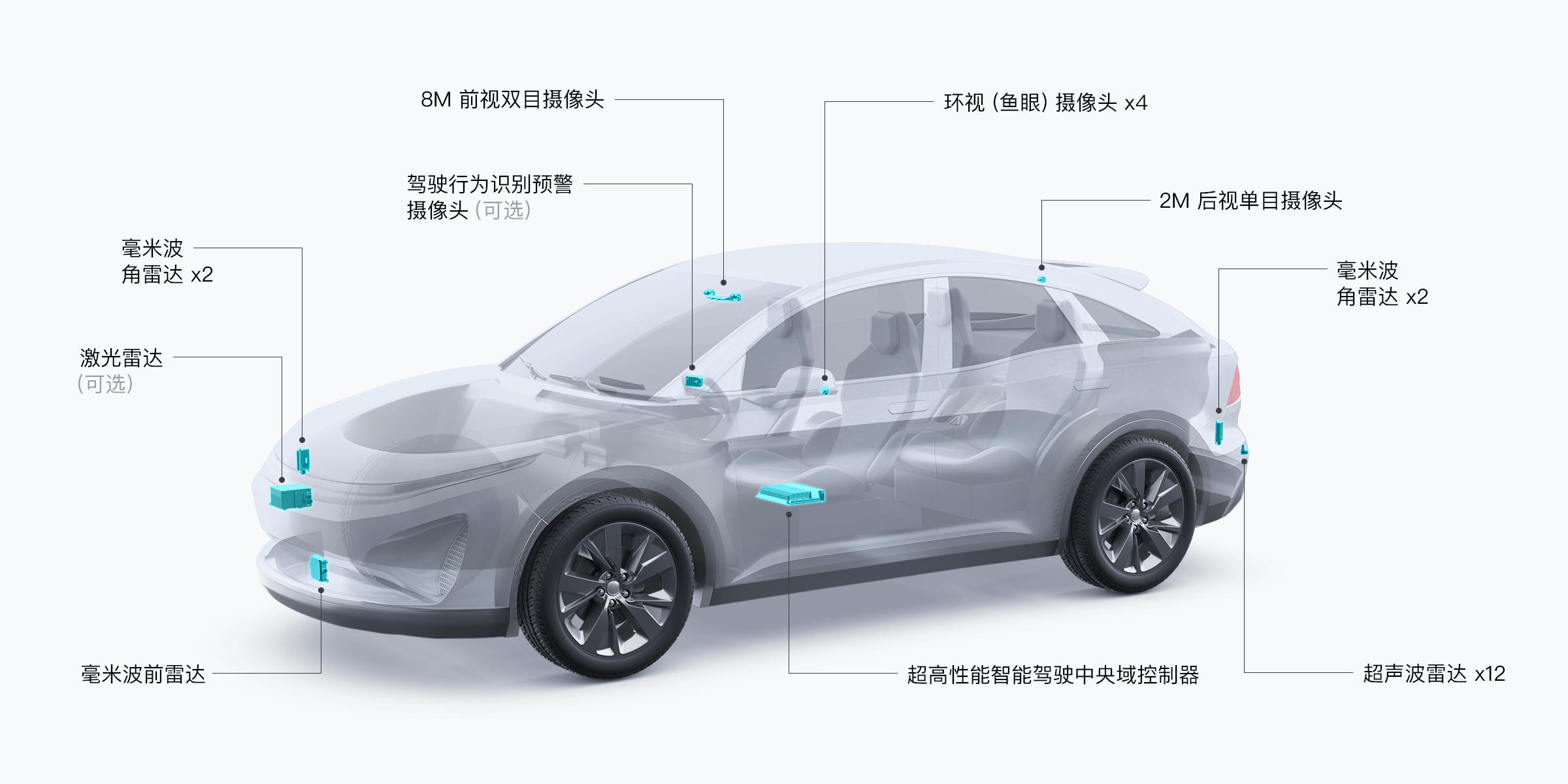

DJI D130

D130是DJI车载的Driving 130解决方案,对应还有D80版本,这里以D130为例,其覆盖 0 至 130 km/h 速度区间,适用于高速路与城市快速路等场景。

传感器方面,D130使用了多种传感器融合的方案,激光雷达、毫米波、相机、超声波均有,其中激光雷达为DJI自产的Livox,相机采用双目2K或环视鱼眼等,并同样使用了12个超声波雷达做避障。

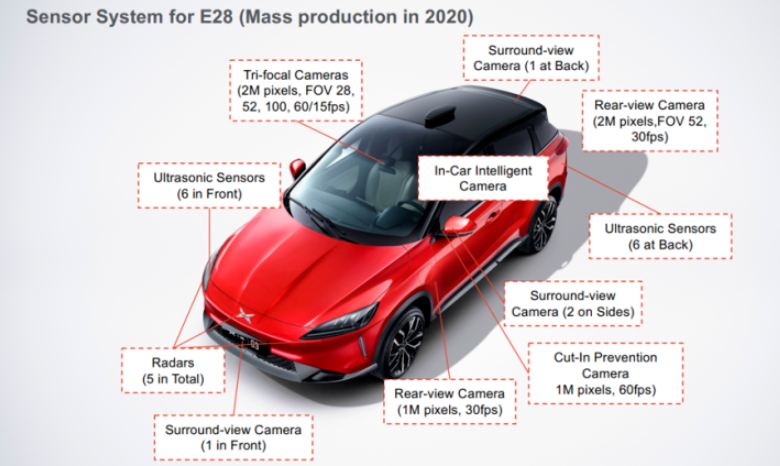

小鹏P7 xpilot

小鹏P7 XPILOT 3.0系统配备了13个摄像头(前三目、4颗ADAS摄像头、4颗泊车360环视摄像头、1颗车内人脸识别摄像头、1颗行车记录仪摄像头)、5个毫米波雷达、12颗超声波雷达、双频高精度GPS,还支持高精度地图定位以及V2X技术。

- 前视三目+后视,2MP

- 远距离 HFOV28, 1828x948, 15fps,可以感知150m左右,用于AEB(自动紧急刹车)、ACC(自适应巡航)和前向碰撞预警

- 中距离 HFOV52, 感知30-70m,用于交通信号灯检测(会看红绿灯)、AEB、ACC、前向碰撞预警和车道感知

- 近距离 HFOV100,感知40m以内,用于交通信号灯检测(会看红绿灯、应该是辅助主前向摄像头的)、雨量检测(自动雨刮要靠它)和防加塞(看的角度更广)

- 后视 HFOV52,帧率30fps,用于ALC、盲区检测和追尾预警

- 左右侧视+后视,HFOV 100,应该都是1M像素,400度覆盖

- 侧前视 两个 60fps

- 侧后视 两个 30fps

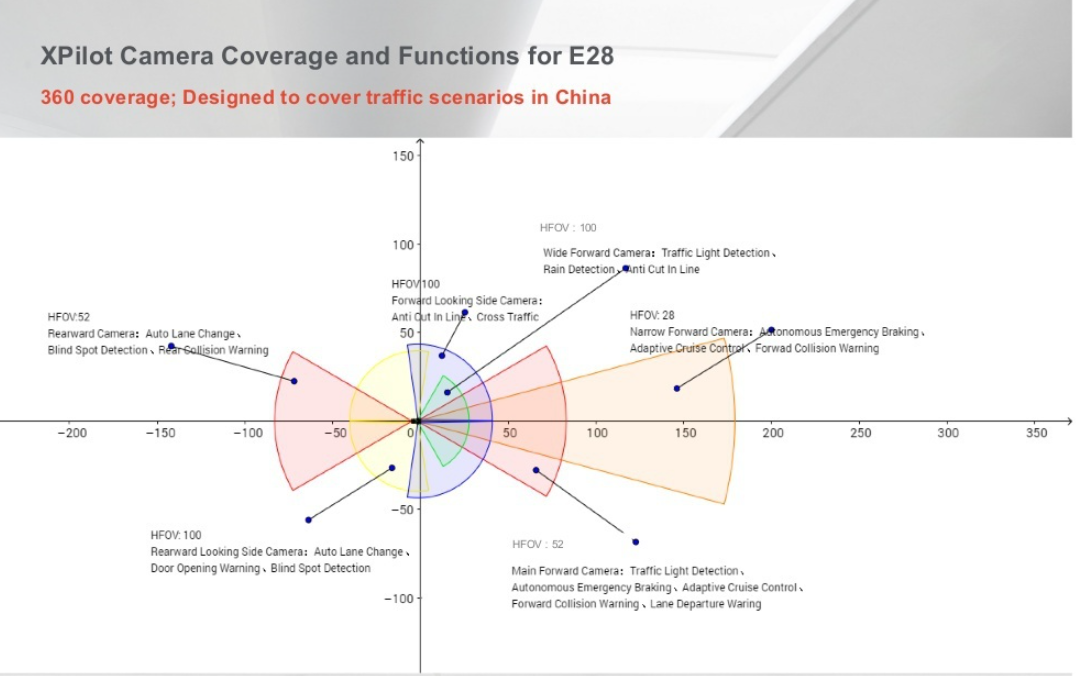

以上覆盖的视角如下图

此外,还搭配了环视相机,应该位于左右后视镜以及前后部分,用于泊车。以及标配的12个超声波雷达,前后各6个。

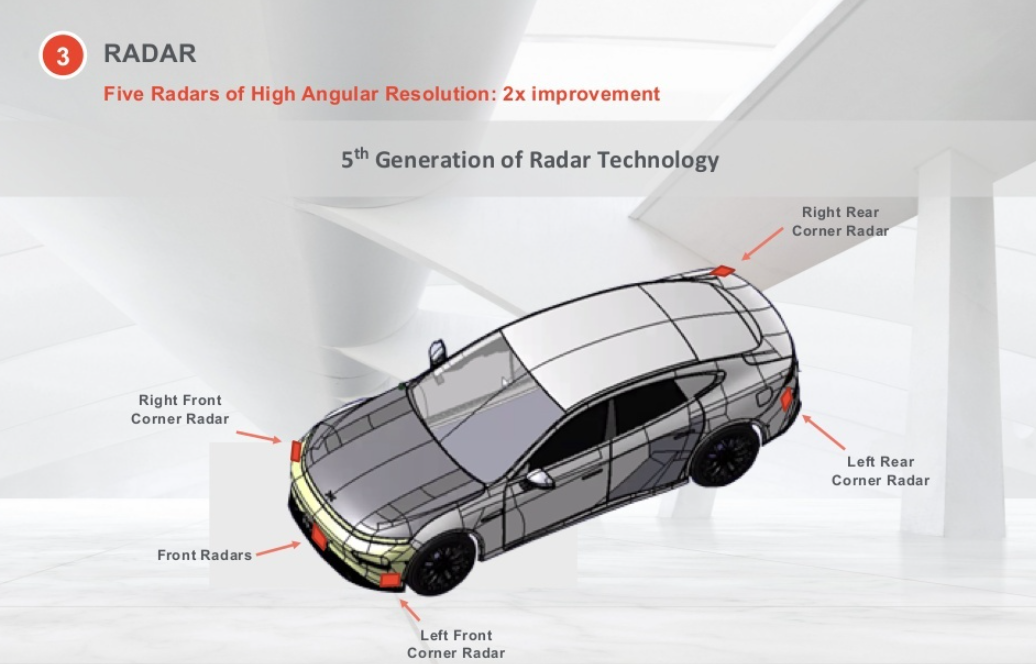

毫米波方面,使用了5个,同样沿车身分布,前3后2.

L2传感器方案总结

- 12个超声波雷达覆盖ego周身是标配,前4后4左2右2

- 对于L2而言,激光雷达是选配,相机才是感知的核心

- 前视需要满足不同距离的感知要求

- 左右两侧一般会放置各2个的侧向相机,侧前/侧后,而且一般覆盖ego周身360度

- 环视鱼眼也是标配方案,用于泊车等场景。